Cloud+Security Forum - IA générative : nouveau défi pour la cybersécurité ?

Dans un contexte où l’IA générative se déploie rapidement dans divers domaines, elle pose des défis important pour la sécurité numérique. Les capacités de cette technologie à produire des contenus réalistes ouvrent de nouvelles perspectives, mais aussi de potentielles vulnérabilités. L'IA ajoute de nouveaux défis, autant positifs que négatifs.

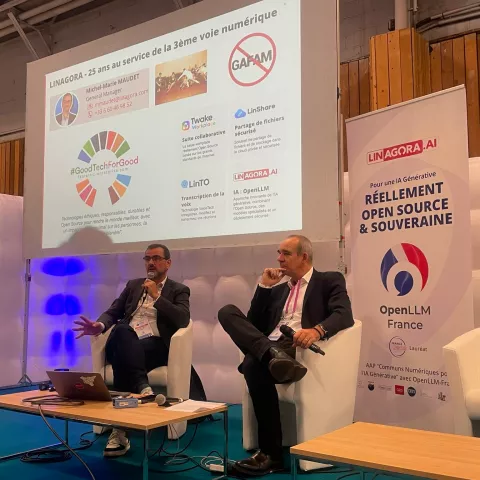

Invité par Fabrice Frossard, Michel-Marie Maudet, le Directeur Général et Co-fondateur de LINAGORA, est intervenu en plénière d'ouverture sur l'impact de ses IAs génératives sur la cybersécurité lors de la nouvelle édition du Cloud + Security Forum.

L'évolution du paysage des cybermenaces à l'ère de l'IA générative

L'avènement de l'intelligence artificielle générative a largement modifié le panorama des cybermenaces : les barrières à l'entrée pour les cybercriminels s'abaissent, entraînant une augmentation significative de la fréquence et de l'intensité des attaques. La disponibilité de services comme le Ransomware-as-a-Service (RaaS) permet à un nombre croissant d'acteurs de lancer des attaques sophistiquées sans avoir de compétences techniques avancées.

Comme l'explique Michel-Marie MAUDET de LINAGORA :

"Pour quelques euros, puisqu'on parle vraiment de petites sommes, et bien, on peut avoir des mécaniques d'attaques complètement automatisées".

Pour environ 40 $ par mois, ces services offrent des robots programmables pour cibler des victimes, avec des modèles de paiement flexibles (abonnements ou partage des gains). Par exemple, si une attaque rapporte 100 000 $, 70 % reviennent à l’utilisateur et 30 % au prestataire criminel, un peu comme une plateforme légitime. Ces offres permettent de lancer des attaques sans expertise technique et à des coûts très bas.

Selon le rapport 2024 de l'ANSSI, les incidents augmentent de 30 %, avec environ 1000 incidents signalés. L'IA facilite la rapidité et l’échelle des attaques, rendant les ransomwares et les attaques de phishing plus accessibles et rapides à déployer.

Cette démocratisation d'outils, comme le voice morphing ou les deep fakes, pose de nouveaux défis pour les professionnels de la cybersécurité, qui doivent faire face à une augmentation du volume et de la sophistication des menaces.

Les références de sécurité à suivre !

Pour se renseigner et contrer ses attaques, Michel-Marie Maudet recommande deux principales ressources : d’abord les guides de l’ANSSI et ensuite l’OWSAP (fondation dédiée à la sécurité).

Le guide de l’ANSSI offre un cycle de vie de l’IA en entreprise, du développement à l’exploitation, et 35 recommandations détaillées. Trois sections y sont identifiées : l’entraînement (à éviter sans préparation, selon l’intervenant), le déploiement initial et l’exploitation quotidienne. L’ANSSI met en avant quelques règles de bon sens, notamment d’intégrer la sécurité dès le début du cycle de vie et d’éviter le "shadow AI" (outils IA non contrôlés). La sécurisation de la chaîne d’approvisionnement est également primordiale, en vérifiant bien les bibliothèques de code avant leur utilisation en production. Une recommandation notable concerne également l’hébergement sécurisé (SecNumCloud), qui impose des conditions coûteuses aux administrations, en particulier en matière de GPU sécurisés, rares en France. Noter, par ailleurs, la norme ISO 42001, relative à la gestion de l’IA dans les systèmes d’information.

Aussi, la fondation OWASP, connue pour son Top 10 des vulnérabilités sur les applications Web, a lancé en 2023 un classement similaire pour l’IA générative et les modèles de langage (LLM). Bien que technique, ce Top 10 identifie les principaux risques en IA, et voici les deux principaux.

- L’injection de prompts : cela consiste à inclure des commandes non sécurisées dans un modèle de langage pour altérer son comportement. Par exemple, un utilisateur pourrait injecter des instructions cachées dans un prompt pour obtenir des informations sensibles. Cela est dangereux, car les modèles, s’ils sont mal protégés, ne filtrent pas correctement les données.

- Fuite d’informations sensibles : sans protections adéquates, un modèle pourrait régurgiter des informations privées lorsque interrogé. Cette faiblesse se pose surtout pour les entreprises utilisant le RAG (Retrieval-Augmented Generation), où le modèle IA accède aux bases de données de l'entreprise pour enrichir ses réponses. Par exemple, si un modèle d’entreprise peut consulter une base de connaissances pour répondre à "Qui a fondé LINAGORA ?", il va chercher dans des documents internes pour fournir une réponse exacte. Cela réduit les hallucinations et permet de sourcer les informations, mais le modèle reste vulnérable aux attaques d’extraction de données.

Enfin, pour se protéger, il est important de configurer la sécurité au niveau du modèle (filtrage, contrôle des accès) et des données pour limiter l’accès non autorisé aux informations sensibles.

Les défis de sécurité liés à l'implémentation de l'IA générative en entreprise

L'intégration de l'IA générative dans les systèmes d'information des entreprises soulève de nouveaux défis en matière de sécurité.

L'un des enjeux majeurs est la protection des données sensibles lors de l'utilisation de modèles de langage (LLM) et de techniques comme le RAG (Retrieval Augmented Generation).

Michel-Marie MAUDET met en garde :

"Dans un modèle, il y a de la connaissance... Et si vous lui posez une question, il met cette connaissance à disposition de n'importe qui.

Donc ça veut dire que l'application qui est connectée et qui va exploiter le LLM, doit absolument faire ce travail de filtrage et de gestion de sécurité".

Pour faire face à ce genre de problème, Michel-Marie recommande l'utilisation d'outils de détection et "d'anonymisation" des données personnelles dans les prompts et les réponses des modèles. Des solutions que l'on retrouve notamment dans des modèles IA Open Source :

"Aujourd'hui, avec OpenLLM, on crée ses alternatives ! ",

Michel-Marie va d'ailleurs donner un exemple concret d'une architecture IA utilisant LLM et RAG. Une démonstration qui met en avant "comment ces vulnérabilités peuvent être exploitées". L'idée est d'appliquer certaines recommandations à une architecture d'application IA typique, intégrant un LLM associé à du RAG. Une solution similaire à celle déployée pour les clients de LINAGORA. Cela permet de sensibiliser aux risques spécifiques, tels que l'empoisonnement des données ou l'extraction d'informations via des attaques de type "prompt injection", qui sont particulièrement faciles à exécuter.

Ce type d'intervention illustre parfaitement la double facette de l'IA en cybersécurité : un risque important, mais aussi une opportunité incroyable pour renforcer nos défenses !

Les opportunités offertes par l'IA dans le domaine de la cybersécurité

Malgré les risques accrus, l'IA générative offre également de nouvelles opportunités pour renforcer la cybersécurité. Les éditeurs de solutions de sécurité et les entreprises spécialisées intègrent de plus en plus l'IA dans leurs outils pour améliorer la détection et la réponse aux menaces.

Michel-Marie MAUDET identifie quatre tendances principales dans ce domaine :

- Automatisation des centres de surveillance (SOC) : les agents IA aident les opérateurs à surveiller les comportements utilisateur et les logs, essentiels pour des systèmes d'information complexes.

- Automatisation des actions et remédiation : Des IAs peuvent désormais automatiser des tâches, comme la collecte de données ou la réponse à des alertes de sécurité, par exemple en fermant des ports vulnérables si un comportement anormal est détecté sur le réseau.

- Renforcement de la défense en profondeur : L'IA surveille les flux internes et les zones de sécurité du réseau pour identifier des comportements potentiellement malveillants, au-delà des protections classiques comme les firewalls.

- Partage de connaissances via OSINT : Le partage d’informations sur les attaques et les vulnérabilités, renforcé par l'IA, permet d'augmenter la résilience de l'ensemble du secteur grâce à l’agrégation et à l’analyse d’informations de sécurité accessibles.

Ces avancées permettent une analyse plus rapide et plus précise des menaces, ainsi qu'une réponse plus efficace aux incidents de sécurité.

Pour rester informés et connectés aux enjeux de l'Intellignece Articificielle en Cybersécurité, suivez les MOOC de l'ANSSI et d'adoptez de bonnes pratiques numériques, essentielles pour sécuriser nos systèmes, qu'ils incluent ou non de l'IA générative.